Wir gehen zurück ins Jahr 2002 - das sind jetzt 22 Jahre

Die "Computerleute" kennen es am besten, nämlich die rasante Entwicklung der Datentechnik nach dem Moorschen Gesetz. Und bei der digitalen Audio-Technik haben wir es mit reinrassiger EDV zu tun. Das ist zum Verständnis dieses Interviews wichtig, denn die nachfolgenden Ausführungen sind inzwischen 22 Jahre alt. Aus diesem Grund sammeln wir hier auch konträre Meinungen insbesondere zu den Themen PCM, DSD / SACD und DVD-Audio.

Das Interview wurde offensichtlich von Audio-Fachleuten für Audio-Fachleute erstellt und viele Abkürzungen sind den Normalos und sicher auch den Ton-Meistern nicht gerade "geläufig" (angesprochen werden ja die mit dieser Technik vertrauten Ton-Ingenieure und nicht die Ton-Meister und schon gar nicht die Hifi-Fans) und deshalb sind viele Fachbegriffe und Abkürzungen erklärungsbedürftig (und werden über Links referenziert - wenn möglich).

.

Stanley Lipshitz's Meinung über "Digital Audio"

Das hier ist ein Artikel aus einem für uns Normalos nicht so bekannten professionellen Audio-Magazins aus dem Jahr 2002. Professor Stanley Lipshitz, einer der wichtigsten Väter digitaler Audiobearbeitung, erläutert im Gespräch die gängigsten Missverständnisse in der digitalen High-End- Audiowelt - einschließlich seiner Bewertung von HD-Audio mit DSD und 96kHz PCM.

Stanley Lipshitz ist einer der weltweit bekanntesten Wissenschaftler und Spezialisten in Sachen „Digital Audio". Die Entwicklung der digitalen Aufnahme- und Wiedergabetechnik begleitet er seit mehr als 20 Jahren. Dabei hat er immer wieder auf gern gemachte Fehler bei der A/D-D/A-Wandlung aufmerksam gemacht und mit seinen Kollegen John Vanderkooy und Robert Wannamaker in einer Reihe von hervorragenden Veröffentlichungen einer ganzen Generation von Audio-Ingenieuren die Notwendigkeit von "Dither" und die Nützlichkeit des Noise-Shapings beigebracht.

.

- Anmerkung : Nicht nur "Dither" und auch "Jitter" müss(t)en hier erklärt werden. Und auch die Grundlagen der EDV-Technik mit Bits und Bytes und LSB, Worten, Wortbreiten und Wortlängen sind für viele Leser unverständlich.

.

"Heutzutage" (es war im Jahr in 2002) ist dank dieser Publikationen längst breit akzeptierte Meinung : Ein nicht einwandfrei geditherters Digitalsystem arbeitet schlichtweg fehlerhaft. Seit einiger Zeit diskutiert Lipshitz nun vehement eine Technologie, bei der erst gar keine hinreichende Ditherung eingesetzt werden kann, womit sich unvermeidbar nichtlineare Fehler einschleichen: Es handelt sich um das der SACD zu Grunde liegende, eigentlich veraltete (???) 1-bittige DSD-Format, welches von Sony und Philips nichtsdestotrotz unter Aufwendung erheblicher Ressourcen gefördert wird.

.

- Anmerkung : Das hier ist Lipshitz' eigene Meinung, die von anderen "Experten" über Jahre sehr kontrovers diskutiert wurde.

.

Das Experten-Thema „DSD vs. Multi-Bit PCM"

Bei der diesjährigen AES Convention in München (es wäre die AES Tagung in 2002) leitet Stanley Lipshitz einen großen Workshop zum "Digital Signal Processing", der sich unter anderem auch dem Thema „DSD vs. Multi-Bit PCM" widmen wird.

Dabei wird sich unter anderen auch Philips SACD-Chefingenieur Derk Reefman bemühen, den 1-Bit-Ansatz zu verteidigen. Vorab gab Stanley Lipshitz uns in einem Interview ausführlich Auskunft über den von ihm betreuten Themenkomplex „Digital Audio".

.

Der persönliche Werdegang von Stanley Lipshitz

.

Der Interviewer PP fragt :

Stanley, können Sie uns erzählen, was Sie zu Digital Audio gebracht hat?

Stanley Lipshitz antwortet :

Mein Kollege John Vanderkooy und ich (der Kern der Audio Research Group der Universität Waterloo in Ontario, Kanada) begannen uns erstmalig ernsthaft für Digital Audio zu interessieren, als Sony im Jahre 1982 den Konverter PCM-F1 für die Benutzung mit Betamax-Videorecordern einführte. Das war ungefähr ein Jahr vor dem Startschuss für die CD in Europa und Nordamerika. Wir hatten schon vorher kurz mit früheren Digitaladaptern experimentiert, aber die waren zu teuer und zu umständlich (und gar nicht mal so gut) und bedingten außerdem die Benutzung eines U-matic-Videorecorders.

.

- Anmerkung : Das stimmt nicht, es gab auch auf Video 8 und VHS basierende Panasonic A/D und D/A Wandler.

Wir kauften einen ersten PCM-F1 Wandler und unsere frühen Labor-. Messungen zeigten, dass er im 16-Bit-Modus exzellent war. Aber im 14-Bit-Modus ließen sich Reste von Quantisierungs- verzerrungen erkennen. Uns wurde klar, dass wir im 14-Bit-Modus das Resultat eines leicht „unter-ditherten" A/D-Konverters sahen. Im 16-Bit-Modus war der A/D-Konverter hingegen gut durch sein internes Rauschen gedithert. Wir begannen, uns für Fragen hinsichtlich Quantisierung und Dither zu interessieren - ein Interesse, welches bis zum heutigen Tag anhält.

Das Thema Quantisierung von analogen Audio-Informationen

Das Thema Quantisierung (also die Erzeugung der Audio-Daten-Datei) ist herausfordernder als die Abtastung (der CD oder DVD oder SACD). Das Abtasttheorem ist ein mathematisches Resultat, welches (zumindest im Prinzip) die Fähigkeit garantiert, ein bandbegrenztes Signal völlig ohne Verluste und Fehler abzutasten und anschließend zu rekonstruieren. So ein Theorem gibt es hingegen für die Quantisierung nicht.

Der Quantisierungsprozess führt stets zu einem nicht zu reparierenden Fehler. Das Beste, was wir tun können, ist zu garantieren, dass dieser Fehler einen rauschartigen und signalunabhängigen Charakter annimmt. Um dies zu erreichen, muss man dem Nutzsignal vor der Quantisierung ein Dither-Rauschen mit bestimmten statistischen Eigenschaften zufügen. Dies wurde seinerzeit von der Audiogemeinschaft noch nicht richtig verstanden.

Ich erinnere mich noch daran, als Nakamichi einige Jahre später ihren ersten sehr teuren DAT-Recorder mit getrennten Gehäusen für Laufwerk und Elektronik herausbrachten. Sie brüsteten sich damit, dass die Elektronik derart rauscharm ausgelegt wurde, dass der A/D-Konverter von den internen Rauschquellen her völlig unge"dithert" blieb. Tatsächlich war dies aber vielmehr sehr schlechte Schaltungstechnik, die aus Unwissenheit, was die Anforderungen an eine verzerrungsfreie A/D-Wandlung angeht, hervorging.

Diese Zeiten sind lange vorbei. Die gesamte Audiogemeinschaft begreift nun die Notwendigkeit einwandfrei geditherter Signal-(Re)quantisierung bei jedem Signalverarbeitungsschritt, bei dem Genauigkeit verloren geht. Es sind die Ingenieure, die vielfach noch nicht diese Notwendigkeit anerkannt haben.

.

Als die CD eingeführt wurde ......

Auf jeden Fall hat das Auftauchen von erschwinglichen Digital-Audio-Adaptern, gefolgt von der Einführung der CD, unser Interesse an der Erforschung der gesamten Quantisierungsthematik geschürt.

Die mathematische Theorie von subtraktivem Dither wurde bereits 1964 von Schuchman entwickelt, allerdings sind für Digital Audio nur nicht-subtraktive Ditherverfahren praktikabel - und für die gab es noch keine veröffentlichte Theorie.

Ich freue mich, sagen zu können, dass wir geholfen haben, diese Lücke zu füllen. Die mathematische Theorie von nicht-subtraktivem Dither ist nun vollständig entwickelt, wird gut verstanden und ausgiebig beim digitalen Signal-Processing angewandt. Ich muss meinen Mitarbeitern John Vanderkooy und Robert Wannamaker für das Erreichen dieses Ziels danken.

Die Notwendigkeit von "Dither"

Interessanterweise veröffentlichten wir zwar als erste die Notwendigkeit von Dither mit dreiecksverteilter Wahrscheinlichkeitsdichte (TPDF s. Triangulär Probability Density Function) zur Unterdrückung von Quantisierungsverzerrungen und Rauschmodulation. Es stellte sich allerdings später heraus, dass Tom Stockham von Soundstream bereits seit 1980 dessen Eigenschaften kannte und auch einsetzte.

Stockham behielt sein Wissen aus geschäftlichen Gründen allerdings für sich! Der Soundstream Digitaleditor profitierte davon erheblich.

Seit den 1980zigern haben wir zahlreiche Live-Demonstrationen von Sampling, Quantisierung und Dither in ganz Nordamerika gegeben, auch auf den AES Conventions. Damals wurden die Grundlagen von Digital Audio noch nicht so gut durchblickt. Unsere kleine 10-Bit-Versuchs- schaltung kam sehr häufig zum Einsatz!

.

Zusätzliche Info-Grafik

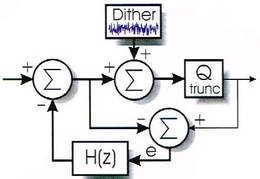

Ein Blick in die Requantisierung - der Zusatz von Dither

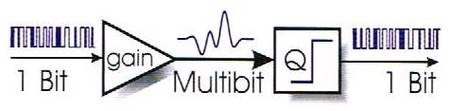

Eine Requantisierung ist an verschiedenen Stellen der digitalen Signalverarbeitungskette, spätestens aber bei der Kürzung der Wortlänge für die finale D/A-Wandlung erforderlich. Keinesfalls aber dürfen die niederwertigeren Bits, die nicht mehr in das Ausgangswort passen, einfach abgeschnitten werden, da dies zu groben Verzerrungen bei kleinen Pegeln führen würde. Vielmehr muss der Quantisierungsfehler durch den Zusatz von Dither vom Signal „dekorreliert" und in ein von ihm unabhängiges weißes Rauschen überführt werden.

Durch Rückführung des beim Rundungsprozess auftretenden Ouantisierungsfehlers über ein Filter auf das Eingangssignal lässt sich das Ouantisierungsrauschen nun „spektral formen" (Noise Shaping). Im einfachsten Fall besteht das Rückkopplungsfilter aus einer Verzögerung um ein Sample, man spricht dann von Fehlerrückführung (Error Feedback) erster Ordnung.

Für In-Band Noise Shaper oder gar Requantisierer für das 1-Bit DSD-Format kommen allerdings stets Filter höherer Ordnung zum Einsatz.

.

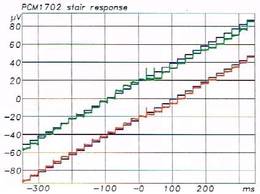

Die differentielle Linearität der A/D-und D/A-Konverter

Mit der differentiellen Linearität der A/D- und D/A-Wandler (Konverter) war es in den Anfangstagen der digitalen Audiotechnik nicht immer zum besten bestellt, was zu hörbaren Unsauberkeiten insbesondere beim Nulldurchgang des Signals führte.

Die differentiellen Nichtlinearitäten sind beispielsweise die Achillesferse der D/A-Konverter mit lasergetrimmter R2R-Leiter, selbst die besten verfügbaren Exemplare dieser Gattung leiden noch in gewissem Maß an dieser Schwäche.

Die Abbildung zeigt die Antwort zweier 20-Bit Konverter PCM 1702 J von Burr Brown (die über viele Jahre das beste waren, was der Markt hergab) auf eine Treppenstufenfolge mit der Stufenhöhe 1 LSB. (zur Unterscheidbarkeit um ±20 uV auseinander gerückt, blau unterlegt ist jeweils der Idealverlauf).

Um den Nullpunkt herum sind deutliche Abweichungen von der idealen Kennlinie und zusätzlich ein paar Glitches (kurze Transienten beim Umschalten) zu sehen. Diese Unregelmäßigkeiten sind noch harmlos, Konverter der ersten Jahre der CD-Technik litten mitunter an erheblich gröberen Störungen.

Mit dem Aufkommen der Sigma-Delta-Konverter verschwanden diese Probleme, dafür war anfangs deren Signal/Rauschabstand noch nicht so hoch.

.

Die Sünden der Pionierzeit

.

Der Interviewer PP fragt :

Die Fehler der Anfangsjahre (der Digitalisierung), in denen die Unabdingbarkeit von Dither und der Nutzen von "Noise Shaping", so wie es breit in Ihren Papern propagiert wurde, noch nicht von vielen Professionellen der Audiobranche begriffen wurde, haben der Digitaltechnik viele Feinde geschaffen.

Noch heute gibt es eine respektable Gemeinschaft von Audiophilen, die das gute alte Vinyl bevorzugen. Diese Leute lehnen digitale Tonträger wegen ihres „harschen, kalten, metallenen" Klangs ab. Ist diese Feindschaft gegen Digital Audio noch gerechtfertigt, wenn man mal von heutiger Wandler-Technologie und einwandfreier Signalverarbeitung in der gesamten Aufnahmekette ausgeht ?

.

Stanley Lipshitz antwortet weiter :

Nun, einige der ersten CDs zeigten auf Grund von Ouantisierungsfehlern in der Tat alle möglichen Artefakte bei der Wiedergabe von geringen Pegeln. Einige dieser Macken waren das Resultat von ungeditherter oder achtloser Arithmetik in den ersten Audio-Editoren, aber viele (vielleicht die meisten) der schlimmen Fehler ergaben sich auf Grund von beträchtlichen differentiellen Nichtlinearitäten in den verwendeten A/D-Wandlern.

Die besten A/D-Konverter dieser Zeit waren noch nicht sonderlich stabil, und wenn sie nicht richtig abgeglichen waren, konnten die Fehler hörbar werden. Aus genau diesem Grunde hat die US-Firma Soundstream vor jeder Aufnahmesession ihre A/D- und D/A-Konverter abgeglichen. Wie ich hinterher erfahren habe, haben sie dabei ein vom Computer generiertes ge-"dithertes" Testband benutzt, mit dem sie zuerst ihre sukzessiven Approximations-D/A-Konverter bitweise getrimmt haben.

Danach wurden die A/D-Konverter eingestellt (justiert), indem ihr Signal über die nun abgeglichenen D/A-Konverter wiedergegeben wurde. Dies alles verhalf der Firma zu einem beneidenswerten Ansehen bezüglich Klangqualität.

.

Ein Klavierkonzert von Mozart - fürchterliche Verzerrungen

Einer meiner Freunde ist ein erstklassiger Pianist. In den frühen Tagen der CD kaufte er sich einen preisgünstigen CD-Player, der ihm viel Freude bereitete. Eines Tages allerdings rief er mich an und meinte, irgendwas könne mit seinem CD-Player nicht stimmen. Er hatte gerade eine neue digital gemasterte CD (deren Namen hier ungenannt bleiben soll !) eines Klavierkonzertes von Mozart erworben.

Bei der Wiedergabe entdeckte er fürchterliche Verzerrungen bei sämtlichen Piano-Passagen. Unsere Nachforschungen ergaben, dass die D/AKonverter seines CD-Players zwar nicht gerade sonderlich linear waren, der eigentliche Schuldige aber tatsächlich die Aufnahme war - der A/D-Konverter, der vom Aufnahmeingenieur verwendet wurde, hatte um den Nullpunkt herum jede Menge Missing Codes, was zu extremer Signalverfälschung führte.

Diese war in den leisen Passagen besonders gut hörbar. Ich selbst fand heraus, dass viele der frühen CDs eine weniger extreme Art von Ouantisierungsproblem aufwiesen: Es war auf klassischen Aufnahmen ziemlich ähnlich, das Hintergrundrauschen vor dem Verstummen „spucken" zu hören, wenn zwischen den Tracks herunter-gefadet wurde. Diese Rauschmodulation ergab sich ganz klar aus der Benutzung von unpassend gedithertem Editor-Equipment.

.

Zu dem SONY PCM-F1 kam ein SONY PCM-701 Wandler hinzu

Auf jeden Fall hatten wir unseren PCM-F1 (und wenig später einen Sony PCM-701), die über mehr als 15 Jahre für lokale Konzertmitschnitte eingesetzt wurden. Deswegen wussten wir, dass diese ganzen Artefakte völlig unnötig waren. Wir wussten, dass richtig gemachte Digitalaufnahmen hervorragend waren.

In der Zeit zuvor hatte ich Analogaufnahmen gemacht und wusste, wie schwierig es ist, mit dieser Technologie durchgehend exzellente Resultate zu erzielen. Ich bin auch heute noch beeindruckt, wie gut die alten Analogbänder "klingen" können.

Trotzdem, mit Digitaltechnik kann man zuverlässig bessere Resultate erzielen, wenn die Gerätschaften ordnungsgemäß ausgeführt und aufgebaut sind - die Sony-Digitaladapter hatten eine ausgezeichnete Schaltungstechnik. Die digitalen Verzerrungen der ersten CDs gehörten bald der Vergangenheit an.

.

Mehr über die Entwicklung der digitalen Aufnahmetechnik

Innerhalb von wenigen Jahren entwickelten sich diese Fehler zu eher unüblichen Vorfällen und heutzutage sind sie tatsächlich rar geworden. Man darf nicht vergessen, dass sich die in den frühen Tagen der CD herausgegebenen Aufnahmen in den vorangegangenen Jahren angesammelt hatten, wobei launische und oftmals dem Prototypenstadium nicht entwachsene Digitalrecorder und -Editoren zum Einsatz kamen.

Zudem war seinerzeit der Entwicklungsstand der Konvertertechnologie selbst bei optimaler Funktion noch unzureichend. Es ist töricht, eine gesamte Technologie auf Grund ihrer Fehlschläge und Kinderkrankheiten abzuurteilen. Der Erfolg zeigte klar, dass das Problem nicht die Theorie, sondern die Praxis war.

Der lineare Frequenzgang der Aufnahme-/Wiedergabekette ließ die hochfrequenten Resonanzpeaks vieler Studiomikrofone zu Tage treten - Peaks, die vormals halfen, den Roll-off der ehemals analogen Aufnahme-/Wiedergabekette zu kompensieren. Es dauerte nicht lange, da wurde nach Mikrofonen mit glatterem Frequenzgang verlangt!

Es gibt in der Tat noch Leute, die Vinyl auf Grund des Wohlklangs einiger Verzerrungen mögen, aber es handelt sich letztendlich trotzdem immer noch um Verzerrungen (einige andere Verzerrungsarten werden hingegen keinesfalls als vorteilhaft angesehen]. Ich bezweifele, dass es heutzutage noch viele Aufnahmeingenieure gibt, die glauben, dass eine Vinyl-LP einen Klang liefern kann, der näher am originalen Mikrofonsignal liegt als das digitale Master. Audiophile, die an die Überlegenheit von Vinyl glauben, haben noch nicht die Möglichkeit gehabt, es mit dem Original zu vergleichen,

.

Der Interviewer PP fragt :

Bevor ein Master für eine Vinyl-Ausgabe geschnitten wird, müssen doch zunächst die hochfrequenten Transienten limitiert werden, weil sie sonst eine zu große Auslenkung der Nadel aus der Mittelposition verursachen würden, welche sie sogar springen lassen könnte.

Für Digitalaufnahmen existiert diese Beschränkung nicht. Könnte es sein, dass diese für die RIAA-Vorverzerrung nötige Peak-Limiterung sich ebenfalls wohlklingend auswirkt, wobei der Effekt diesmal insbesondere bei hohen Pegeln zu hören ist?

.

Stanley Lipshitz antwortet : zum Thema Verzerungen

Ich finde, dass alles, was einen Aufnahmeingenieur dazu veranlasst, die Präzision seiner Aufnahme auf Grund von spezifischen Beschränkungen des Aufnahmemediums zu verändern, eine Art von Verzerrung in dem Sinne darstellt, dass die Aufnahme vom Original abweicht - selbstverständlich immer unter der Annahme, dass „das Original" tatsächlich eine akkurate Repräsentation des originalen Klangs ist.

Vinyl-LP und analoge Bänder haben beide ihre spezifischen Begrenzungen, die gewisse Kompromisse bei der Aufnahme erfordern. Multi-Bit-PCM- Digitalaufnahmen, die heutzutage üblicherweise ohne Preemphasis durchgeführt werden, weisen lediglich eine Peak-Overload-Beschränkung auf, welche frequenzunabhängig ist und deshalb nicht zu solchen Schwierigkeiten führt.

Viele Aufnahmeingenieure haben sich mit Fehlern wie der dankbaren Kompression analoger Bandaufnahmen bei hohen Pegeln angefreundet und nutzen sie absichtlich. Solche Effekte können legitimen künstlerischen Nutzen haben, aber es sind auf jeden Fall Ungenauigkeiten.

Es ist befremdlich, dass Audiophile oft Verzerrungen akzeptieren, von denen sie nichts wissen - wie z. B. Kompression auf analogen Bändern oder nichtlineare Lautsprecher- bzw. Mikrofon- Frequenzgänge, während sie aber gleichzeitig Dingen wie Klangregelung an ihren Wiedergabegeräten unnachgiebig gegenüberstehen.

.

Wohlklingende Verzerrungen

Es gibt eine ganze Menge wohlklingender Verzerrungen - sowohl lineare, wie z. B. Frequenzgang, und nichtlineare, wie Kompression - die manche Hörer für erhöhte Akkuratesse halten. Über Geschmack lässt sich nicht streiten, aber Akkuratesse ist nun mal wissenschaftlicher Festlegung unterworfen; und zu der Kategorie wissenschaftlicher Tests zähle ich ordnungsgemäß durchgeführte „blinde" Hörversuche.

.

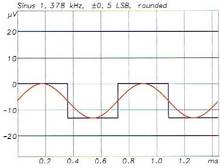

Zusätzliche Info-Grafik : Die Sünden der Anfangsjahre:

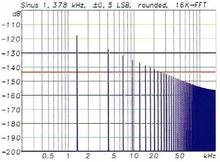

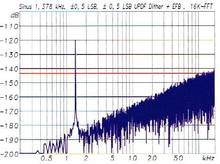

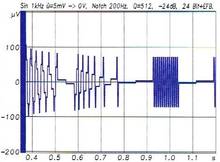

Vielfach wurde das Digitalsignal beim Übergang auf geringere Wortlängen nicht korrekt gedithert, was zu deutlich hörbaren Verzerrungen - insbesondere bei leisen Passagen - führte. Die Abbildung zeigt anhand eines 20-Bit D/A-Konverters, wie sich das auswirkt.

Ausgegangen wird hier von einem Sinussignal mit einer Amplitude von ±0,5 LSB bezüüglich des D/A-Konverters) und 8 x Oversampling. Bei der schlichten Rundung (von einer damalls deutlich höheren Wortbreite) entsteht eine reine Rechteckschwingung (Anmerkung : solch ein Unsinn - es gibt keine Rechteckschwingungen, nur periodische Rechtecksignale oder besser mäanderförmige "Signale") mit 1 LSB Amplitude; das niederwertigste Bit klappert also mit der Frequenz des ehemaligen Sinussignals hin und her.

Im Frequenzbereich (rechts) manifestiert sich dementsprechend das typische Oberwellenspektrum einer Rechteckschwingung. Eingezeichnet ist als rote Linie außerdem der Pegel des analogen Ausgangsrauschens eines guten 20-Bit-Konverters. Sämtliche auf das Audioband fallenden Oberwellen liegen oberhalb des Rauschens und sind tatsächlich wahrnehmbar.

.

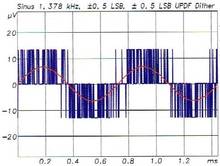

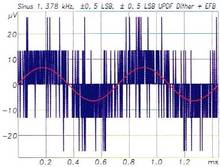

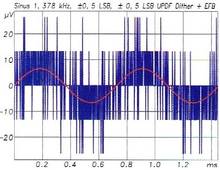

Zusätzliche Info-Grafik : Dither rauschen

Addiert man zum Signal vor der Rundung ein passendes Dither-Rauschen (im Beispiel mit ±0,5 LSB gleichverteilter Amplitudendichte, zur vollständigen Beseitigung aller korrelierten Artefakte wäre streng genommen ±1 LSB dreiecksverteilte Amplitudendichte erforderlich), so verschwinden die Oberwellen.

Stattdessen erhält man ein weißes Grundrauschen, welches im Beispiel glücklicherweise deutlich unter dem analogen Ausgangsrauschen des zugrunde gelegten DA-Wandlers (S/N: 114 dB) liegt und deshalb dessen Dynamikumfang so gut wie nicht (um -0,15 dB) verschlechtert.

Der Dither transformiert also den unvermeidlichen Ouantisierungsfehler: Er verwandelt die unerwünschten korrelierten Verzerrungen in statistisch unabhängiges weißen Rauschen.

Ein korrekt gedithertes Digitalsystem verhält sich genau so wie ein analoges: Verstummende Töne versinken verzerrungsfrei im Rauschteppich und bleiben noch ein Weilchen hörbar, selbst nachdem ihre Amplitude schon deutlich unter die des LSBs abgesunken ist! Ein nicht adäquat gedithertes Digitalsystem wie das in Abb. 3) arbeitet schlicht fehlerhaft.

.

Die gute alte Emphasis

.

Der Interviewer PP fragt :

In der Anfangszeit der CD wurde die 50/15us- Emphasis noch ziemlich häufig benutzt, insbesondere bei klassischen Aufnahmen. Auch heutzutage hat noch jeder CD-Player ein eingebautes De-Emphasis-Filter, welches üblicherweise mit hoher Präzision auf der digitalen Ebene in den Oversamplingstufen der D/A-Konverter realisiert ist und bei Detektion einer vorverzerrten CD automatisch eingeschaltet wird.

Diese Emphasis erhöht den Dynamikumfang im Mitten-Hochtonbereich sehr effektiv, denn die Amplitude der Komponenten in diesem Frequenzbereich ist sowohl bei Sprache als auch bei Musik üblicherweise viel geringer als die der Bässe.

Deswegen kann dieser Bereich normalerweise gefahrlos durch die Pre-Emphasis angehoben werden, ohne dass der Pegel der Gesamtaufnahme merklich zurückgenommen werden müsste. Die Emphasis wäre ja sogar noch wirkungsvoller, wenn sie mit In-Band-Noise-Shaping verbunden würde, letzteres am besten mit spezieller Anpassung an die 50/15us-Kurve. Haben Sie eine Erklärung dafür, warum die Emphasis trotz dieser bedeutsamen Vorteile heutzutage gemieden wird?

.

Stanley Lipshitz antwortet :

Meine Erklärung dafür ist der Glaube einiger Leute, auf den ich schon in meiner vorigen Antwort angespielt habe, dass jegliche Klangregelung „böse" ist. Die Pre-/De-Emphasis Filter sind nun mal auch Klangregler.

Tatsächlich handelt es sich um völlig harmlose Shelving-Filter. Bob Stuart von der englischen Firma "Meridian Audio" sowie - in einigen seiner Artikel - auch Michael Gerzon haben jahrelang darauf hingewiesen, dass die Kombination des 50/15us-Standards der CD mit einer komplementären Noise-Shaping-Kurve sinnvoll wäre.

In der Tat könnte man auf diese Weise der ehrwürdigen CD ein weiteres Bit an Signal/ Rauschabstand abgewinnen. So ließe sie sich als längst einsatzbereiter, kostenfreier Träger für den größeren Dynamikumfang von 20- und 24-Bit-Master-Recordings nutzen.

Die Signalprozessoren von der Firma Meridian bieten diese Option auch tatsächlich an. Ich stimme Ihnen zu, dass es wirklich Sinn machen würde. Unglücklicherweise ist es nicht immer Sinn, der zu den Entscheidungen unserer Industrie führt.

.

Die Pre-Emphasis Ignoranz

Übrigens begegnen mir mehr und mehr Beispiele von Equipment, welches keine automatisch zuschaltbare De-Emphasis mehr beinhaltet. Viele der gängigsten hochqualitativen Soundkarten für Computer ignorieren das Pre-Emphasis-Daten.....g völlig !

Außerdem übernehmen fast alle der üblichen CD-Recording-Programme (ich denke da an Corel/Adaptec/Roxios „CD Creator"-Produktlinie) das Pre-Emphasis-Flag beim digitalen Kopieren von CD-Tracks, die mit Pre-Emphasis aufgenommen wurden, nicht korrekt.

Das Resultat ist dann bei der Wiedergabe eine 10dB-Überhöhung im Hochtonbereich. Als ich den Hersteller darauf aufmerksam machte, wussten die Herren noch nicht mal, was Pre-Emphasis überhaupt ist!

Nachdem ich es ihnen erklärt hatte, entschied man sich dafür, sie nicht weiter zu berücksichtigen, weil ja „heutzutage nur noch so wenig CDs Pre-Emphasis benutzen" !

Sogar die Zeitschrift „Stereophile" hatte bei zahlreichen Geräten ohne korrekt funktionierende De-Emphasis immer wieder ein Nachsehen - mit der gleichen unlogischen Begründung. Ein Hersteller einer als erstklassig bewerteten Soundkarte, die ebenfalls keine De-Emphasis zuschalten konnte, kommentierte, dass er eben an minimale Audiosignalverarbeitung glauben würde!

Können Sie das fassen? Das ist gleichbedeutend mit dem Verkauf eines hochqualitativen Tapedecks ohne Dolby-Decoder - mit der Begründung, dass letzterer im Interesse von minimaler Signalverarbeitung herausgehalten wurde. Oder mit dem Bau eines Phono-Vorverstärkers ohne RIAA-De-Emphasis!

.

Der Interviewer PP fragt :

Nun, wenn so viele der CD-Recorder-Programme und Soundkarten das Pre-Emphasis-Flag schlicht ignorieren, wäre das nicht ein Anreiz für die Phonoindustrie, absichtlich wieder Pre-Emphasis auf den CDs zu benutzen?

Das wäre dann eine Art neuer Kopierschutz: Der Verbraucher würde

seine unautorisierte Kopie mit dem Original vergleichen und - ohne zu wissen, was da vor sich geht - feststellen, dass sie deutlich „harscher, kälter und metallener" klingt .....

Was den Klangfilter-Charakter der Emphasis-Filter angeht: Eine Kombination von hintereinander geschaltetem Pre- und De-Emphasis-Filter weist, wenn perfekt abgestimmt (was bei digitaler Realisierung ja überhaupt kein Problem ist) einen absolut linealglatten Amplituden- und Phasengang auf, also so, als wäre gar kein Filter eingeschleift gewesen. Sollte dies nicht auch die hartnäckigsten Puristen zufrieden stellen?

.

Stanley Lipshitz antwortet :

Einige Puristen glauben, dass jedes Filter (von dessen Existenz sie etwas wissen) die Reinheit des Signals beeinflusst. Die Filter, von denen sie nichts wissen, sind offenbar okay, denn die wurden von ihnen ja schließlich noch nicht kritisiert.

Technisch gesehen haben sie in dem Sinne Recht, dass jede Form von Filterung, selbst komplementäre Pre-/De-Emphasis, nicht mathematisch perfekt ausgeführt werden kann. Aber ich glaube, dass De-Emphasis sowohl im Analogen wie auch im Digitalen vom Höreindruck her perfekt durchgeführt werden kann - in letzterem Fall muss die Wortbreite der Signalverarbeitung aber selbstverständlich größer als 16 Bit sein und der nachfolgende D/A-Kon-er muss ebenfalls mehr als 16 Bit annehmen.

Bei der A/D-Wandlung erzielt man den größten Nutzen bezüglich Dynamikumfang-Erhöhung natürlich dann, wenn die Pre-Emphasis analog vor dem A/D-Konverter durchgeführt wird. Der Vorschlag, die Pre-Emphasis zur Vereitelung von unerlaubten Digitalkopien zu verwenden, ist herrlich bösartig!

.

Fehler bei der Signal Verarbeitung

.

Der Interviewer PP fragt :

Welches sind die häufigsten Fehler, die in DSP-Algorithmen (das wäre die Software in den "Digitalen Signal Prozessoren") gemacht werden und die dann zu Signalverschlechterungen führen?

.

Stanley Lipshitz antwortet :

Quantisierungsbedingte Fehler manifestieren sich auch innerhalb der digitalen Signalverarbeitung und sind ein üblicher (vermutlich der üblichste) bleibender Fehler. Das gilt besonders für Festkomma-Verarbeitung, da man extrem darauf achten muss, das Signal dergestalt im Zahlenbereich des Prozessors zu skalieren, dass man einerseits zwar nur wenig an Dynamikumfang verliert, aber andererseits niemals ins Clipping gerät. Aus diesem Grunde werden in Festkomma-Editoren stets größere Wortlängen verwendet, als sie auf dem finalen digitalen Datenträger zu finden sind.

Aber sogar bei Fließkomma-Processing ist die Länge der Mantisse {die letztendlich die Genauigkeit festlegt) häufig kleiner, als man es eigentlich gerne hätte. Selbst hier muss man also darauf achten, nicht ungebührlich an Genauigkeit einzubüßen.

Wenn ein Fest- oder sogar ein Fließkommasignal schließlich in die gewünschte Wortlänge für die CD (oder DVD-Audio oder sogar SACD, wobei letzteres ein Extremfall ist!) umgewandelt wird, muss unbedingt eine geeignet geditherte Wortlängenreduktion durchgeführt werden, wenn die Qualität erhalten bleiben soll.

.

Arithmetische Rundungsfehler in rekursiven Filtern

Zu den DSP-Algorithmen, die wegen arithmetischer Rundungsfehler den größten potenziellen Oualitätsverlust aufweisen, gehören die rekursiven (IIR) Filter. Die Rückkopplung innerhalb der Filterstruktur bedingt Rundungsfehler in einer Art, die bei nicht rekursiven (FIR) Filterarchitekturen nicht auftauchen.

Praktische Beschränkungen der Hardware und Effizienz-Erwägungen bedingen die Benutzung von IIR-Filtern für viele Equalisierungsaufgaben und es ist ja auch nichts grundsätzlich Schlechtes an ihnen - es ist nur schwieriger, sie transparent zu gestalten.

Die gesamte Klasse der Noise-Shaping-Filter, die ja die Basis der meisten Wortbreiten-Reduktions-Algorithmen bilden (inklusive des 1-Bit-Sigma-Delta-Modulators, der das Herzstück des SACD-Systems darstellt) basieren auf Fehler-Rückkopplung und sind deswegen von Natur aus rekursiv.

Es gibt noch ein paar ungeditherte Noise Shaper und Sigma-Delta-Modulatoren, obwohl sich einfach zeigen lässt, dass solche Schaltungen Rauschmodulation und schwachpegelige Grenzzyklen-Schwingungen sowie weitere nichtlmeare Artefakte produzieren, wenn sie nicht vernünftig gedithert werden.

Bis auf den 1-Bit-Sigma-Delta-Modulator (der die Basis der DSD-Modulation für die SACD bildet) kann bei allen korrekter Dither appliziert werden - deswegen gibt es auch keine Entschuldigung dafür, es nicht zu tun. Der 1-Bit-Modulator kann hingegen nicht hinreichend gedithert werden, ohne überfahren zu werden.

Dies ist einer der Gründe dafür, dass alle hochqualitativen A/D- und D/A-Wandler heutzutage mehr als ein Bit benutzen - in der Praxis drei bis fünf. Der 1-Bit-Modulator kann allerdings immerhin so weit gedithert werden, dass die meisten der nichtlinearen Effekte unhörbar bleiben. Wir empfehlen, wie auch von anderen bestätigt, so viel Dither wie möglich in 1-Bit-Modulatoren anzuwenden.

.

Der Interviewer PP fragt :

Ist der Hauptgrund für das Aufkommen der Multi-Bit Sigma-Delta-Konverter nicht, dass sich mit 1-Bit-Designs auf Grund des unvermeidbaren Jitters des Abtast-Taktes kaum S/N-Verhältnisse oberhalb von, sagen wir mal, 105 dß erzielen lassen ?

.

Stanley Lipshitz antwortet :

Ich glaube, das ist nicht der einzige Grund. Die Wandler-Hersteller - z. B. Bob Adams von Analog Devices, ein extrem kenntnisreicher Ingenieur - sagen, der Hauptgrund ist die Unmöglichkeit, alle Grenzzyklen sowie die durch Nichtlinearitäten entstehenden Intermodulationen zu beseitigen.

Wegen der sehr hohen Amplitude bis zur Nyquist-Frequenz hinauf und der enormen Menge an Noise Shaping im Audioband ist eine Unterdrückung dieser Inteimodulationsprodukte um mehr als 100 dB erforderlich, wenn sie unhörbar bleiben sollen. Das ist eine harte Anforderung.

.

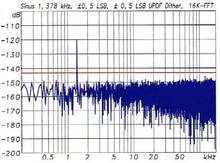

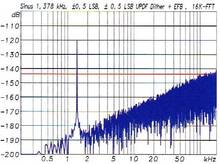

Zusätzliche Info-Grafik

Die geringfügige Verschlechterung des S/N-Verhält- nisses durch Zusatz von Dither lässt sich für das Audioband (insbesondere bei Verwendung höherer Abtastraten) durch Noise Shaping wirkungsvoll umgehen. Hier wurde die einfachste Form, eine Fehlerrückführung (Error Feedback) bei 8 x 44,1 kHz, angewandt.

Die spektrale Verteilung des Ouantisierungsrauschens bekommt dadurch eine 6dB-Dachschräge verpasst. Das Rauschen liegt nun im ganzen Audiobereich mehr als 15 dB unter dem analogen Ausgangsrauschen des Beispiel-D/A-Wandlers. Bei 0 Hz verschwindet der Ouantisierungsfehler sogar gänzlich.

Die Zunahmen des Ausgangsrauschens durch den Dither ist nun völlig vernachlässigbar (< 0,01 dB), trotzdem wird der Wandler verzerrungsfrei betrieben. Voraussetzung für die praktischen Umsetzbarkeit dieser theoretischen Ergebnisse ist allerdings ausreichende differentielle Linearität des Wandlers.

.

Hohe Abtastraten

.

Der Interviewer PP fragt :

Haben wir was von mehr als 48 kHz Abtastrate? (Anmerkung : Das ist die EBU / AES 48kHz/24bit Norm) ?

.

Stanley Lipshitz antwortet :

Ja, im Prinzip sicherlich, und möglicherweise auch in der Praxis. Zwei Gesichtspunkte spielen bei dem möglicherweise vorhandenen Nutzen eine Rolle. Zum einen die größere Audiobandbreite, obwohl der Beweis für die Wahrnehmbarkeit von Ultraschall noch aussteht. Der zweite ist die größere Flexibilität, die dem Ingenieur beim Design der Tiefpässe, die in jedem digitalen System benötigt werden, zur Verfügung steht. Der breitere Übergangsbereich erlaubt ein Design von Filtern mit besserem Phasengang innerhalb des Audiobereiches.

Allerdings steht auch hier noch der wissenschaftliche Beweis für einen hörbaren Vorteil aus, obwohl viele Leute leidenschaftlich glauben, die Antwort bereits zu wissen. Einige Untersuchungen haben ergeben, dass eine messbare Veränderung der Hirnaktivität eintritt, wenn im Ultraschallbereich Signalkomponenten anzutreffen sind, die statistisch mit dem Signal im Band unterhalb von 20 kHz korreliert sind.

Andere Experimente haben gezeigt, dass mit Breitbandsignalen gespeiste Lautsprecher hörbare Intermodulations-Komponenten bilden können, die nicht im Originalsignal vorhanden sind und sich auch auf den Bereich unterhalb von 20 kHz erstrecken.

Erklärt dies die „Hörbarkeit" von erweiterter Bandbreite? Wenn dem so ist, handelt es sich trotzdem nicht um eine Erhöhung der Genauigkeit bei der Klangreproduktion, selbst wenn die Version mit Ultraschall bevorzugt wird.

Wenn sich die Akkuratesse der Audiowiedergabe tatsächlich erhöhen würde, ließe sich die erhöhte Datenrate, die mit der Bandbreitenerhöhung einher geht, ja noch rechtfertigen. Sonst aber wäre sie barer Unfug.

Unternehmen wie Wadia und Pior haben ein paar törichte Versuchte unternommen, dem Signal von der CD bei der Wiedergabe falsche Ultraschallkomponenten beizumischen. Das haben sie gemacht, indem sie ein bisschen Spiegelband-Energie durch ihre absichtlich schlappen Anti-Alias-Filter nach Lagrange-Spezifikation gelassen haben. Diese Spiegelband-Energie ist auf nichtlineare Weise mit dem Nutzsignal verknüpft.

Dies bedeutet allerdings einen Anstieg von Verzerrungen, nicht etwa der Präzision der Wiedergabe! Da die Ultraschall-Komponenten nun aber mit dem Audiosignal (in welchem sie im Original nicht vorhanden waren!) korreliert sind, könnte ihre Anwesenheit anhand der eben zitierten Forschungsergebnisse tatsächlich wahrnehmbar sein.

.

Der Interviewer PP fragt :

Sind die Vorteile der erhöhten Abtasrate womöglich hauptsächlich technischer Natur? So wird ja die Latenz herabgesetzt (was z. B. wichtig für Echtzeit-Anwendungen ist), es lassen sich leichter IIR-Filter mit „analogerem" Frequenzgang um 20 kHz herum realisieren und außerdem lässt sich der Frequenzbereich darüber als „Quantisierungsmüllkippe" sowohl für die Fehlerrückführung in allen internen Signalverarbeitungsstufen als auch das Noise Shaping bei der finalen Requantisierung nutzen.

Stanley Lipshitz antwortet :

Ich denke, man kann die erhöhte Audio-Abtastrate hauptsächlich als Platzspender zwischen dem oberen Ende des Audiobandes und der Nyquist-Frequenz ansehen, womit sich das Design der Anti-Alias-Filter und die Signalverarbeitung erleichtert. Wenn allerdings das Signal letztendlich auf eine CD gebracht werden soll, muss es zum Schluss auf 44,1 kHz herunter dezimiert werden, wozu dann an dieser Stelle auf jeden Fall ein sehr steiles, bandlimitierendes Filter eingesetzt werden muss.

Sie erwähnen den „analogeren Frequenzgang" der IIR-Filter nahe der halben Abtastrate. Viele assoziieren FIR-Filter mit Linearphasigkeit, aber in Wahrheit haben diese beiden Begriffe nichts miteinander zu tun: FIR-Filter können genauso gut minimalphasig wie IIR-Filter ausgelegt werden, was man auch als „analogartigen" Vorteil ansehen könnte.

Übrigens, obwohl das Abtasttheorem üblicherweise mit Nyquitst (1931) oder Shannon (1949) in Verbindung gebracht wird, geht der frühste mir bekannte Nachweis auf Whittaker im Jahre 1915 zurück. Deswegen müsste es eigentlich „Whittaker's Abtasttheorem" heißen.

.

Der Interviewer PP fragt :

Abstimmbare Filter mit FIR-Topologie sind aber äußerst schwierig zu implementieren. FIR-Filter sind in der Regel nur dann vorteilhaft, wenn ein Filter mit fester Charakteristik benötigt wird. Für programmierbare digitale Equalizer sind aber wohl nur IIR-Filter eine gangbare Lösung, da sich ihre geringe Anzahl von Koeffizienten bei einer gewünschten Änderung der Filtercharakteristik (per bilinearer Transformation oder Interpolation aus Tabellenwerten) leicht neu berechnen lassen.

Stanley Lipshitz antwortet :

Ich stimme zu. Allerdings muss bei der Implementierung dieser IIR-Filter wegen ihrer rekursiven Natur große Sorgfalt walten. Sie sind sehr anfällig für Rundungseffekte, wenn sie nicht anständig gedithert werden.

Zusätzliche Info-Grafik : „Biquad" (Filter zweiter Ordnung)

IIR-Filter in Direktform I. Dieser „Biquad" (Filter zweiter Ordnung) bildet die Basiseinheit der meisten frequenzgangsbeeinflussenden DSP-Algorithmen. Wegen seiner rückgekoppelten Struktur ist das rekursive Filter allerdings sehr anfällig für Grenzzyklen, die sich bei mangelnder Wortbreite unangenehm bemerkbar machen können.

Zur Minderung dieser Störungen kann ein Error Feedback bei der Requantiserung des doppelt genauen Akkumulatorinhaltes durchgeführt werden, so wie hier (als komplette Funktionseinheit) gleich mit eingezeichnet. Für professionelle Audioqualität ist aber trotzdem mindestens 32-Bit Fließkomma- oder 48-Bit Festkomma- Rechnung erforderlich.

.

Kritik an DSD und SACD

.

Der Interviewer PP fragt :

Ist DSD eine technische Sackgasse?

.

Stanley Lipshitz antwortet :

Das Modulationsverfahren 1-Bit-Sigma-Delta des SACD-Systems kann mit Dither nicht vollständig linearisiert werden, da der 1-Bit-Ouantisierer schon clippen würde, bevor die volle Dither-Amplitude erreicht wird. Selbst wenn der 1-Bit-Konverter so weit gedithert wird, wie es eben möglich ist, können sich Grenzzyklen-Artefakte bis zur Nyquist-Frequenz herauf ausbilden - und das tun sie auch tatsächlich.

Es existiert überhaupt keine Dither-Theorie für den 1-Bit-Ouantisierer. Da er nur zwei Ausgangswerte kennt, ist die Leerlaufverstärkung des Quantisierers völlig undefiniert und deshalb gibt es keinen „korrekten" Dither-Pegel für solch ein System - der Pegel des Dithers muss aber an die Verstärkung des Quantisierers angepasst sein.

Sobald man mehr als zwei Amplitudenstufen hat - sogar ein 3-Stufen- (also 1,5-Bit-) Quantisierer tut es schon, ist das Gain wohldefiniert, nun lässt sich eine Dither-Theorie anwenden und es existiert ein korrekter Typ und Pegel von Dither, mit dem sich alle Artefakte unterdrücken lassen.

Wegen des extremen Noise Shapings, welches man benötigt, um einem 1-Bit-System ein S/N-Verhältnis von 120 dB unterhalb von 20 kHz abzuringen (115 dB negatives Feedback sind dazu erforderlich), haben das Ultraschall-Rauschen und die Grenzzyklen-Artefakte eine viel höhere Energie als das Nutzsignal selbst.

.

Der Einfluß auf die nachfolgenden Verstärker

Diese Störanteile dürfen auf keinen Fall die nachfolgenden Komponenten der Audiokette erreichen, denn sonst würden die Hochtöner und Leistungsverstärker durchbrennen und sich außerdem mühelos Intermodulationsprodukte unterhalb von 20 kHz ausbilden. In der Praxis liefert deswegen die 2,8224-MHz- Abtastrate von DSD letztendlich nur ein Passband, dessen linearer Frequenzbereich nicht über 40-50 kHz hinausgeht.

Außerdem nimmt das S/N-Verhältnis oberhalb von 15 kHz drastisch ab. Der riesige Anteil an hochfrequentem Rauschen stellt aber nicht nur ein Problem für die Entwickler der Wiedergabegeräte dar, sondern zieht auch mit sich, dass jeglicher digitalen Verarbeitung von 1-Bit-Signalen eine gleichartige Tiefpassfilterung folgen muss, um Overload in der nachfolgenden 1-Bit- Modulator- Stufe zu vermeiden.

Praktisch jegliche Verarbeitung von 1-Bit-Signalen führt unweigerlich zu einem Multi-Bit-Signal, welches dann mühselig wieder zurück ins 1-Bit-Format gequetscht werden muss, also eine weitere DSD-Wandlung mit all ihren Nachteilen erforderlich macht.

Selbst die simpelsten Operationen, wie z. B. eine Lautstärke-Einstellung, die bei Multi-Bit-PCM eine triviale Operation ist, erfordern extreme Verrenkungen, wenn hinten wieder ein 1-Bit-Signal herauskommen soll.

So ist dann die erreichbare -3dB-Bandbreite von DSD nicht größer als die bei 96 kHz PCM und das erreichbare S/N-Verhältes nicht besser als bei schlichtem 20-Bit-PCM (wobei sogar noch weniger als 20 Bit erforderlich sind, wenn man PCM mit Noise Shaping kombiniert).

.

Die Betrachtung der Bitrate

Einwandfrei geditherte PCM-Systeme lassen sich im Vergleich zu DSD mit der gleichen oder sogar deutlich geringerer Bitrate betreiben, ohne dabei unter irgendeinem der Nachteile von DSD zu leiden.

Moderne Spitzenklassen-A/D- und D/A- Wandler basieren auf Multi-Bit Sigma-Delta-Strukturen (üblicherweise drei bis fünf Bits), weshalb das ursprüngliche „1-Bit-Reinheitsgebot" (das Signal bleibt von A/D bis zu D/A durchgängig in der l-Bit-Ebene) bereits an beiden Enden der Übertragungskette verletzt wird. Er wird außerdem in jeder Signalverarbeitungsstufe gebrochen, da das 1-Bit-Signal dort automatisch zum Multi-Bit-Signal wird, welches wieder auf 1 Bit reduziert werden muss.

Zusätzliche Info-Grafik

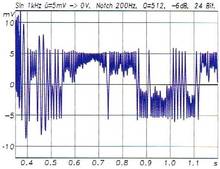

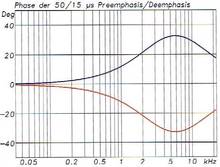

Digitale Signalverarbeitung ist nicht perfekt - und kann sogar zu katastrophal schlechten Ergebnissen führen, wenn die Algorithmik nicht sorgfältig ausgelegt wird. IIR-Filter beispielsweise lassen sich für professionelle Audiozwecke nicht mit 24-Bit-Festkomma-Arithmetik realisieren.

Was passiert, wenn man es dennoch versucht, ist im linken Bild zu sehen: Hier wurde ein Sinussignal mit 5mV Amplitude (FS: 10,95V), welches ein 24-Bit-Notchfilter mit hoher Güte speist, gleich zu Beginn des Signalausschnittes abgeschaltet. Danach herrscht aber nicht etwa Ruhe, sondern es vagabundieren wilde Grenzzykylen, die durch die Rundung auf 24 Bit und die Rückkopplung entstehen, zum Ausgang.

Das Problem lässt sich ganz erheblich durch ein Error Feedback (der beim Runden gemachte Fehler wird vom nächsten Ergebnis vor dem erneuten Runden abgezogen) mildern, wie das rechte Bild zeigt. Die Amplitude der Grenzzyklen hat um mehr als das 20fache abgenommen (man beachte die unterschiedliche Skalierung an der vertikalen Achse). Professionellen Ansprüchen genügende Ergebnisse lassen sich aber erst bei Übergang auf 48-Bit-Arithmetik erzielen.

.

Zusätzliche Info-Grafik

Erst bei durchgehender 48-Bit-Arithmetik sinken die Grenzzyklen eines IIR-Filters auf ein vertretbares Maß ab (linkes Bild), wobei allerdings immer noch Schmutzreste im 24-Bit-Ausgangssignal zu sehen sind. Diese ließen sich weitgehendst beseitigen, wenn auch bei 48-Bit-Arithmetik mit Error Feedback bei der Rundung des Akkumulatorinhaltes gearbeitet würde. Im Spektralbereich (rechts) lassen sich die Fehler unzulänglicher digitaler Signalverarbeitung ebenfalls gut beobachten.

Hierfür wurde dem gleichen Notchfilter diesmal kein Sinussignal, sondern ein Rauschen sehr geringen Pegels (blaue Kurve) zugeführt. Dieses sollte eigentlich gemäß der Filtereinstellungen bei 200 Hz um 24 dB absinken. Die rote Kurve zeigt, dass selbst bei 48-Bit-Verarbeitung stattdessen ein leichter Anstieg zu verzeichnen ist.

Völlig katastrophale Ergebnisse ergeben sich bei reiner 24-Bit-Arithmetik (obere Kurve): Das Rauschen steigt um erschütternde 80 dB an. In dieser Form eignet sich das Filter bestenfalls für Telefonanwendungen. Ein Error Feedback für die 24-Bit-Version bringt zwar 30 dB Verbesserung (grüne Kurve), aber noch keine ausreichende Qualität.

.

Stanley Lipshitz antwortet weiter :

Da ein Multi-Bit PCM-Signal prinzipiell ohne Verlust bearbeitet werden kann, während dies mit einem 1-Bit-Signal nicht möglich ist, lässt sich schwerlich der Anspruch aufrecht erhalten, dass der 1-Bit-Ansatz in irgendeiner Weise überlegen sei.

- Anmerkung : Es gibt kein Wort davon, wen das 1 Bit Signal gar nicht weiter verarbeite werden soll oder muß, sonder analog gewandelt wiedergegeben werden soll ????

Tatsächlich empfiehlt Philips denn auch, dass für die professionelle SACD-Produktion die 32-Bit-PCM Technik mit 352,8 kHz Abtastrate bei der gesamten Verarbeitung und Speicherung bis hin zur finalen 1-Bit DSD-Umwandlung zu verwenden sei.

Auch Sony empfiehlt den Multi-Bit-Ansatz zur professionellen 1-Bit-Produktion, wobei eine 8-Bit-Version von DSD, genannt „DSD-Wide", zum Einsatz kommt. Dafür produziert Sony auch gleich die passende Hardware.

Wäre „PCM-Narrow" ----- richtiger ---- ????

Da ein 8-Bit-PCM-System immer noch erhebliches Noise Shaping (mehr als 70 dB) benötigt, um die gewünschten 98dB S/N (??? stimmt das) im Audioband zu erreichen, erscheint es mir richtiger (??? was ist das ?), es „PCM-Narrow" zu nennen, denn genau das ist es wirklich!

Warum muss für den Endverbraucher das Multi-Bit-Signal eigentlich unbedingt degradiert werden, indem es durch die finale 1-Bit DSD-Stufe gezwungen wird ? Das ergibt für mich keinen technischen Sinn.

Ich nehme mal an, es macht irgendeinen marketingmäßigen Sinn für Sony und Philips. Der professionelle Audioingenieur sollte sich allerdings nicht hereinlegen lassen.

.

Um mich nicht falsch zu verstehen

Um mich nicht falsch zu verstehen, ich behaupte nicht, dass SACD ein schlechtes System wäre. Kann sein, dass es mehr als gut genug für die Allgemeinheit ist. Es scheint nur ein törichter und suboptimaler Weg zu sein, der da eingeschlagen wurde. Ich glaube, dass Multi Bit-PCM der vernünftige und technisch korrekte Weg ist, um höhere Audioqualität zu erreichen.

.

Zusätzliche Info-Grafik

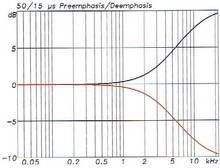

Die Emphasis wurde der CD von ihren Erfindern (das waren auch Philips und SONY) als wahlfreie Option mit in die Wiege gelegt, um das Rauschen in den Mitten und Höhen zu verringern.

Dazu wird vor der Quantisierung auf 16 Bit der Hochtonbereich mittels eines einfachen 6dB-Shelving-Filters (blaue Kurve; RC-Produkte: 50/15us) angehoben. Da die Hochtonanteile in aller Regel eine viel geringere Amplitude aufweisen als die Bässe, braucht dazu der Aufnahmepegel nicht oder nur sehr wenig zurückgefahren zu werden.

Bei der Wiedergabe wird die Anhebung durch das komplementäre De-Emphasis (rot) wieder rückgängig gemacht, und zwar sowohl amplituden- als auch phasenmäßig. Heraus kommt wieder ein linealglatter Frequenzgang.

Das Quantisierungsrauschen - und darin liegt der Clou - wird bei der Wiedergabe aber nun ebenfalls gemäß der De-Emphasis herabgesetzt. Eine mit Pre-emphasis aufgenommene CD rauscht oberhalb von ca. 1 kHz deutlich wahrnehmbar weniger - bei 20 kHz macht die Abnahme fast 10 dB aus.

.

Es gibt auch noch die In-Band Noise Shaper

Besonders günstig ließe sich das Pre-/De-Emphasis-Schema in Verbindung mit In-Band Noise Shapern einsetzen, die ja einen Großteil des Rausches in den Bereich oberhalb von 15 kHz schieben.

Dort würde es von der De-Emphasis gleich um einiges gedämpft, womit sich gut radikalere Noise Shaper mit hoher Rauschminderung unterhalb von 10 kHz einsetzen ließen. Auf diese Weise ließe sich der guten alten CD ohne jegliche Änderung an den Abspielgeräten unterhalb von 10 kHz ein Störabstand entlocken, der nahe an die SACD-Spezifikation (120 dB) herankommt.

Trotz dieser bedeutsamen praktischen Vorteile wird Pre-Emphasis aber heutzutage kaum noch angewandt, was vielleicht darauf hindeutet, dass der Dynamikumfang der CD weder von der Phono-Industrie noch vom Verbraucher als großes Problem angesehen wird.

.

Der Interviewer PP fragt :

Multi-Bit-PCM ist außerdem offen für Erhöhungen sowohl der Abtastrate als auch der Wortbreite, während DSD hinsichtlich beider Aspekte festgelegt ist und deswegen nicht von Verbesserungen der Konvertertechnologie profitieren kann. Tatsächlich ist DSD technisch ja längst durch das Aufkommen der Multi-Bit Sigma-Delta-Konverter überholt worden, oder?

- Anmerkung ; Das war einer der Hauptgründe, dieses Thema von 2002 in 2024 wieder aufzugreifen. Die Techik macht nun mal sehr große Sprünge und manche dieser Aussagen kann sich durchaus ins Gegenteil verändert haben.

.

Stanley Lipshitz antwortet :

Korrekt. Außerdem kann Noise Shaping in Multi-Bit PCM-Systemen ebenfalls angewandt werden, wobei dazu aber überhaupt keine Veranlassung besteht, wenn die Wortlänge groß genug (sagen wir mal 24 Bit) ist.

Die DSD-Abtastrate ist gerade mal eben hoch genug, um die 120 dB S/N bis 20 kHz zu erreichen. Das S/N verschlechtert sich bereits oberhalb von 15 kHz drastisch. DSD würde sehr von einer höheren Oversampling-Rate als 64x profitieren. Ich schätze aber mal, dass 64x das höchste der Gefühle war, um noch ausreichend Spielzeit auf Multikanal-SACDs zu erzielen.

Wenn die Herren das 1-Bit-Format aufgeben würden, gäbe es überhaupt keine Daseinsberechtigung mehr für das SACD-System. So ist denn alles, was sich machen ließe, eine Erhöhung der Oversampling-Rate.

Ja, und die besten verfügbaren A/D- und D/A-Wandler basieren auf oversampeln der 3- bis 5-Bit-Sigma-Delta Topologie. 1-Bit-Wandler wurden aus Oualitätsgründen fallen gelassen. Sowohl Sony als auch Philips stimmen zu, dass für professionelle Produktionen ein Format mit mehr als einem Bit benutzt werden muss - sie stimmen bloß nicht darin überein, wie viele Bits (8 oder 32) es denn sein sollen.

.

Der Interviewer PP fragt :

Wenn man der Diskussion von Studioleuten folgt, denen ein direkter Vergleich von Multi-Bit-PCM zu DSD möglich war, so scheint es eine leichte Präferenz für die DSD-Version zu geben. Wenn überhaupt ein Unterschied wahrgenommen wird, dann wird die DSD-Aufnahme als geringfügig „sanfter, luftiger" beschrieben.

Nun geben aber dieselben Leute zu, dass diese Charakteristik größtenteils erhalten bleibt, wenn man die DSD-Version zu Multi-Bit-PCM mit 96 kHz konvertiert. Ist dies nicht ein glasklarer Beweis dafür, dass die hochgradige HF-Verseuchung der 1-Bit-Aufnahme für diesen Weichzeichner-Effekt verantwortlich ist?

.

Stanley Lipshitz antwortet :

Das kann ich wirklich nicht sagen, da ich nie an einem solchen Experiment teilgenommen habe. Allerdings ist das Vorgehen, zwei Aufnahmen untereinander zu vergleichen, nicht gleichbedeutend mit dem Vergleich zum originalen Signal und der Auswahl, welches der beiden näher an dieser ultimativen Referenz liegt.

Präferenz ist nicht unbedingt das Gleiche wie Akkuratesse. Wenn tatsächlich einige der „hörbaren Vorteile" von DSD nach der Konvertierung zu PCM erhalten bleiben, dann zeigt dies zumindest eins:

Was auch immer DSD da einfängt, PCM kann es auch speichern! Dies lässt in der Tat vermuten, dass die DSD-Version der Realität die falsche ist - auch, wenn manche sie bevorzugen. Ich glaube, dass ein ultimatives Aufnahme/Verteil-System das Signal nicht hörbar beeinflussen sollte.

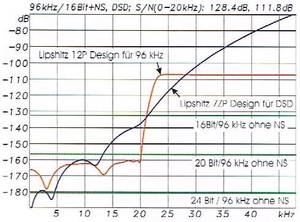

Zusätzliche Info-Grafik - links oben

Während DSD ohne extremes Noise Shaping gar nicht lebensfähig wäre, lassen sich wesentlich moderatere Noise Shaper bei Multi-Bit-PCM optional einsetzen, um im Audiobereich die Auflösung deutlich zu erhöhen. Auf diese Weise lässt selbst eine 16-Bit/ 96-kHz-Aufnahme die SACD alt aussehen: Das versuchsweise Design von Stanley Lipshitz (rote Kurve) drückt den Noise-Floor im gesamten Audiobereich bis 20 kHz deutlich unter 20-Bit Niveau (mittlere grüne Kurve).

Resultierender Dynamikumfang (0-20 kHz): 128,4 dB. Da kann DSD auch mit ausgefeilteren Shapern als dem hier gezeigten Design (blaue Kurve) kaum mithalten. Während das Gesamtrauschen der 96 kHz-Aufnahme mit dem hier gezeigten Noise Shaper lediglich auf -70,7 dBFS ansteigt, ist es bei DSD mit +9 dBFS grundsätzlich erheblich stärker als das eigentliche Nutzsignal!

Statt nun aber mit Noise Shapern den durch zu knappe Wortbreiten bedingten unzureichenden Dynamikumfang im Audioband zu reparieren, lässt sich die Aufnahme auch gleich mit 24 Bit machen (untere grüne Kurve): Der dadurch erreichbare Dynamikumfang ist deutlich größer als der unseres Hörsinns, es wird kein unsinniger HF-Schmutz auf dem Distributions-Medium transportiert und die erste Ultraschall-Oktave wird in voller Auflösung mit übertragen.

Trotzdem liegt die Bitrate einer 24 Bit/96 kHz Aufnahme noch merklich unter der einer SACD. Die DVD-A(Audio) kann qualitätsmäßig sogar noch einen drauflegen: Mit 24 Bit bei 192 kHz bietet sie einen Qualitätsstandard, der auf absehbare Zeit von der Technik gar nicht eingehalten werden kann.

.

Zusätzliche Info-Grafik - rechts oben

Jede DSD-Signalverarbeitungsstufe, selbst eine simple Lautstärkeänderung, verwandelt das 1-bittige DSD-Signal sofort in ein „ganz normales" Multi-Bit-PCM-Signal. Dieses kann nur durch eine erneute verlustbehaftete Requantisierung wieder ins 1-Bit-Format gebracht werden. Dabei werden dem Signal ein weiteres Mal nicht vollständig unterdrückbare Verzerrungen, Grenzzyklen und vor allem ungeheure Mengen an HF-Schmutz zugefügt.

Letzteres bedingt, dass nach nur zwei oder drei DSD-Signalverarbeitungsstufen mit Requantisierung Übersteuerungen auftreten würden. Zu deren Vermeidung müssen Tiefpässe eingeführt werden, welche die Bandbreite der SACD auf 40 bis 50 kHz beschränken.

Wegen dieser und anderer Nachteile haben sich Sony und Philips längst von der Idee der 1-bittigen Signalverarbeitung verabschiedet und empfehlen für die SACD-Aufnahme- und Studiotechnik ganz normales Multi-Bit-PCM Processing (mit Abtastraten ab 350 kHz).

Somit kommt auf der gesamten Aufnahmeseite das 1-Bit-Format überhaupt nicht mehr vor. Erst beim finalen Mastering für die SACD wird auf DSD herunter konvertiert. Auf Playerseite wird das DSD-Signal vor der DA-Wandlung durch ein „DSD-Filter" wiederum in ein Multi-Bit Signal überführt.

Es stellt sich die Frage: Wozu dann überhaupt noch dieses 1-Bit-Nadelöhr mit all seinen Nachteilen?

.

Der Interviewer PP fragt :

Was könnte denn die Ursache für den offenbar angenehmen Einfluss des hochfrequenten Rauschens der SACD sein? Wäre es denkbar, dass der HF-Schmutz ähnlich wie z. B. auch bei analogen Tonbandgeräten als Bias fungiert, der das Audiosignal um die Nulldurchgänge herum linearisiert? Oder ist es wahrscheinlicher, dass der hohe HF-Pegel die Härchen in der Cochlea vorstimuliert und so zu einer leichten subjektiven Betonung der höchsten wahrnehmbaren Frequenzen führt?

.

Stanley Lipshitz antwortet :

Beide dieser sehr interessanten Hypothesen wären denkbare Erklärungen für diesen Effekt, wenn er denn wirklich existiert.

Unser Innenohr ist der hochgradig nichtlinearer Empfänger, allerdings kann durch den extrem steilen mechanischen Tiefpass, den unser Mittelohr darstellt, nur sehr wenig Ultraschallenergie zu ihm vordringen. Das Mittelohr selber ist ziemlich linear. Wenn das Ultraschallsignal schon gar nicht erst in die Cochlea eindringen kann, kann es dort auch nicht die Umwandlung in Nervenimpulse beeinflussen.

Kann es das bisschen vom Lautsprecher abgestrahlte Ultraschallenergie tatsächlich durch das Mittelohr hindurch bis in die Cochlea schaffen - mit einem Pegel, der irgendeinen wahrnehmbaren Effekt mit sich bringen würde? Das erscheint mir zweifelhaft, und Hörexperten auch. Allerdings gibt es keinerlei Zweifel daran, dass jegliche Verstärker- oder Lautsprecher- Intermodulations- verzerrung, die in das Audioband fällt, potenziell hörbar ist.

Dass dies in der Praxis auch tatsächlich auftritt, wurde auf der letztjährigen AES Convention in Amsterdam anhand von Forschungsergebnissen berichtet. Ich halte mich mit Beurteilungen über diese Spekulationen lieber zurück. Ich gebe aber zu, dass einem „Dither-Menschen" wie mir ihre Ideen verlockend erscheinen, denn Dither agiert in der Tat sehr ähnlich wie die Hochfrequenz-Vormagnetisierung bei analogen Bandgeräten; und ein wenig Ultraschall-Rauschen könnte möglicherweise die Schallumwandlung innerhalb des Audiobandes beeinflussen.

.

Der Interviewer PP fragt :

Könnten wir vielleicht diejenigen, die von der klanglichen Überlegenheit von DSD überzeugt sind, mit einem „Inject DSD-HF-Noise"-Schalter auf der Frontplatte eines DVD-A-Players befriedigen?

Bei Betätigung würde dann dem sauberen Signal der DVD-A ein Rauschen beigemischt, dessen spektrale Verteilung dem eines SACD-Players entspricht. Auf diese Weise könnten wir doch vermutlich den gleichen Weichzeichner-Effekt erwarten?

Stanley Lipshitz antwortet :

Die Idee zum „Injizieren von DSD-HF-Rauschen" ähnelt der Einführung von Rekonstruktionsfiltern in Langrange-Manier, auf die ich bereits anspielte. Sie erlauben es, dass ein Teil der Spiegelband-Energie das reproduzierte Signal begleiten darf. Die Unternehmen, die das

gemacht haben, behaupten, der Grund dafür sei die „verbesserte" Impulsantwort (weniger Ringing) des D/A-Wandlers.

Die ultimative Impulsantwort - nur ein Sample breit - könnte man erreichen, wenn man überhaupt kein Rekonstruktionsfilter verwenden würde! Dann würde man die gesamte Spiegelband-Energie ab 22,05 kHz bis unendlich durchlassen. Glücklicherweise wollten sie dann aber doch nicht so weit bei diesem törichten Unterfangen gehen.

Der durchgelassene Ultraschall könnte allerdings in gleicher Weise wie das Hochfrequenz-Rauschen der SACD wirken, beide sind mit dem Audio-Nutzsignal korreliert, stehen aber in keinem linearen Verhältnis zu ihm. Wenn die Korrelation zwischen Nutzsignal und Ultraschall-Störkomponente wirklich wichtig für die Wahrnehmbarkeit ist, so wie das einige Untersuchungen angedeutet haben, dann müsste der zuschaltbare Ultraschall-Rauschgenerator genau wie ein DSD-Modulator korrelierte Rauschkomponenten produzieren.

Die einfachste Weise, dies zu erreichen, wäre schlicht der Einbau einer 1-Bit-DSD Sigma-Delta-Modulatorschaltung! Die würde genau den richtigen Mix an Artefakten erzeugen, um das gewünschte Resultat zu erzielen. Und würde mit allen Eingangssignalen zusammenarbeiten, unabhängig von der Quelle.

.

Vergangenheit und Zukunft von Digital Audio

.

Der Interviewer PP fragt :

Hochauflösendes Audio mal im Allgemeinen betrachtet : Sind wir nicht längst an einem Punkt angelangt, an welchem die Wandler einen derart hohen Dynamikumfang und so geringe Verzerrungen erreichen, dass Beschränkungen der vor- und nachgeschalteten Analogtechnik sowie Umweltgeräusche als Fehlerquellen auf den Aufnahmen überwiegen ?

Welches wäre ein vernünftiges Endziel für den Dynamikumfang eines Aufnahmesystems? Sind 192 kHz/24 Bit mehr, als wir jemals würdigen können?

.

Stanley Lipshitz antwortet :

In der Tat! Die Aufnahmesysteme können mittlerweile kaum noch von den Konzertsälen, Mikrofonen sowie der analogen Elektronik mit Signalen versorgt werden, die eine Herausforderung an ihr erreichbares S/N-Verhältnis darstellen würden.

Sogar eine 16-Bit-CD mit Noise Shaping (insbesondere eine, die komplementäre Pre-/De-Emphasis nutzt) übertrifft in der Regel den Dynamikumfang solcher Signale. Professionelle Recording-Ingenieure brauchen einen komfortablen Headroom für Produktionszwecke.

Es erscheint mir, dass 20 bis 24 Bit mehr als genug sind, um selbst die kritischsten Bedürfnisse menschlicher Wahrnehmung zu befriedigen. Ich glaube außerdem, dass 192 kHz Abtastrate Overkill ist.

Wir warten immer noch auf gute experimentelle Daten, die eine wahrnehmbare Klangtreuenverbesserung durch eine Bandbreitenerweiterung auf weit über 20 kHz belegen würden - Bandbreitenerweiterung beinhaltet nach meiner Definition auch damit einhergehende Phaseneffekte. Diese Experimente müssen allerdings auch alle nicht mit der größeren Bandbreite zusammenhängende Effekte der Abtastratenerhöhung berücksichtigen.

.

Der Interviewer PP fragt :

Vielleicht war es ein großes Glück für den Konsumenten, dass Sony bei der CD-Entwicklung auf 16 Bit bestanden hat, während Philips seinerzeit nur 14 Bit wollte. Womöglich ist dies nun schlecht für beide Firmen, da die Qualität von 16 Bit/44,1 kHz-PCM so hoch ist, dass 99% der Verbraucher gar kein dringendes Bedürfnis nach einem neuen Format verspüren - von der verlockenden Möglichkeit zur Multikanal-Wiedergabe einmal abgesehen.

Stanley Lipshitz antwortet :

Ich glaube, wir können froh sein, dass die CD als 16-Bit-System eingeführt wurde. So wie ich das verstehe, hatte Philips seinerzeit einen guten 14-Bit-D/A-Konverter entwickelt, da sie auch mit einem 14-Bit-Prototypen der CD arbeiteten.

Sony überzeugte sie dann aber, dass die CD ein 16-Bit-Format sein solle. Sony hatte bereits einen 16-Bit-D/A-Konverter in der Schublade. Philips löste das Problem mit dem 14-Bit-Konverter, indem sie ihn mit vierfachem Oversampling und Noise Shaping (in diesem Fall schlichte Fehlerrückführung erster Ordnung) betrieben, um ihm 16-Bit-Performance (zumindest bei tieferen Frequenzen) zu entlocken.

So ist denn die Idee, auf Konsumentenebene Multi-Bit Noise Shaping zu betreiben, bereits 20 Jahre alt (Anmerkung : das war 1979).

Neu und wirklich beschränkend sind weder Oversampling noch Noise Shaping, sondern vielmehr die 1-Bit-Restriktionen der SACD. Ich fürchte, dass Sie Recht haben - die Mehrheit der potenziellen Verbraucher hat mehr Interesse an Multikanalfähigkeit (sogar mit verlustbehafteter Kompression) als an Super Fidelity.

.

Der Interviewer PP fragt :

Was glauben Sie, wo es mit Digital Audio hingehen wird? Wird die DVD-A oder gar die SACD die Welt erobern und tatsächlich die CD ersetzen?

Oder ist es wahrscheinlicher, dass komprimierende Datenformate wie MPEG2/Layer3 schließlich diese Rolle einnehmen werden?

.

Stanley Lipshitz antwortet :

Ich fürchte eher, dass sowohl die SACD als auch die DVD-A kommerziell scheitern werden. Sie sind nicht lebensfähig, wenn sie nur von Audiophilen unterstützt werden.

Die große Mehrheit der Verbraucher bewertet Bequemlichkeit und Preisgünstigkeit leider (Anmerkung : Wieso "leider" ????) viel höher als Qualität. Sie hören einfach nicht die fürchterlichen Verzerrungen, die von exzessiver Datenkomprimierung ausgehen können und es oft auch tun.

Oder sie werden toleriert, wenn sie doch gehört werden. Haben Sie sich jemals den Klang eines tragbaren „40 Sekunden shock protected" CD-Players angehört? Die ich mir angesehen habe, besitzen 2 Mbyte RAM, während 8 Mbyte erforderlich wären, um diese Datenmenge verlustfrei zu speichern.

Früher waren es immer „10 Sekunden shock protected", bis irgendwer damit begann, die größere Zeit anzupreisen. Für 10 Sekunden wäre der Speicher perfekt. Bei 40 Sekunden scheint es so zu sein, dass viele Hersteller einfach drei von vier Samples ohne saubere Dezimation oder psychoakustisch basierte Kompression herauswerfen.

Wie der Leser sich schon denken kann, bevorzuge ich ein PCM-basiertes Format als sinnvollsten Weg zur Qualitätserhöhung über den CD-Standard hinaus. DVD-A ist solch ein Format - oder sollte ich besser „Formate" sagen? - und ich würde es gerne siegen sehen.

So lange aber die Öffentlichkeit nicht klar dieses Format unterstützt, werden es die großen Musikunternehmen ebenfalls nicht tun und es könnte sein, dass dann der kleinste gemeinsame Nenner den zukünftigen Standard setzt. MP3 mit gängiger Datenrate wäre so ein kleinster gemeinsamer Nenner.

Ich glaube, die CD wird noch ein gutes Weilchen welterleben!

Diese (RAW-) Interview führte Swen Müller im Jahr 2002

Die Kommentare und Ergänzungen stammen aus 2024

.

Es gibt natürlich auch noch andere Meinungen aus jüngerer Zeit

Anmerkung aus 2024 : Einer der wesentlichen Kritikpunkte an diesen Äusserungen von Herrn Lipshitz ist die Tatsache, daß das 1 Bit DSD Verfahren (laut SONY) nie für eine hier bemängelte Weiterverabeitung gedacht war. Es war als unveränderliches Endprodukt konzipiert. Da stellt der Herr Professor Forderungen auf, die nicht (nie) real (gewesen) sind. Ganz sicher standen die Umgehung von irgendwelchen Patenten und die "perfekte" Kopierschutz- Möglichkeit im Vordergrund der Entwicklung.

Das beste Beispiel für solche künstlich "gezüchteten" Mißveständnisse sind die BOSE 901 Boxen. Die Firma BOSE und deren Chef, der Professor Bose, hatten nie behauptet oder gar irgendwo beworben, daß diese Speaker/Equalizer- Kombination irgendetwas mit "Edel-Hifi" oder gar "High-End" zu tun hatte. Das Wort Hifi kam anfänglich gar nicht vor. Irgendwelche Hifi-Freaks wolllten sich damit hervortun oder profilieren, die BOE 901 könne ja gar kein High-End.

Die Kernaussage von BOSE war über Jahrzehnte : Die BOSE 901 würden "lediglich !!!" den Konzertsaal ins Heim bringen - und das taten sie damals auch richtig gut, schon fast grandios.

.